中国储能网讯:

摘要

近年来,电网调控领域智能化发展趋势明显,但由于人工智能(artificial intelligence,AI)技术本身的黑盒性质,正确性和可靠性验证问题日渐重要,能够支持各种不同人工智能模型验证的复用性支持平台尤为重要。通过对验证需求和问题的分析,提出一种包含基础设施、平台服务和应用服务的3层验证平台架构,分析了该架构下AI模型验证的运行模式,开展了案例和样本复用、容器化和镜像、多框架和算法集成等关键技术研究,并进行了开发和实施。该平台实现了算力和数据资源的统一管理和复用、兼容支持多种不同AI框架和算法库、验证场景的动态生成等,为后续调控领域人工智能技术推广应用奠定了基础。

01

验证平台架构设计

1.1 基本设计思路

在统一进行安全管理和系统调度的基础上,验证平台设计的主要目标和实现思路如下。

1)可支持各种不同规模、基础框架和算法库的机器学习模型的验证。规模的伸缩性,可通过云计算虚拟化和容器部署技术予以支持。当前存在Scikit-learn、Tensorflow、Pytorch、Keras等多类主流框架,而AI模型和框架之间客观上存在紧耦合性,可在部分支持跨框架序列化的基础上,综合应用引擎管理、容器和镜像机制予以支持。

2)可灵活构造验证案例,实现样本复用。调控领域的AI验证案例,实际上由电网信息模型以及与之关联的样本数据组成。案例的构建需要首先选择目标电网信息模型,然后抽取相关联的样本数据,再结合相关环境信息形成。可基于历史数据、仿真数据、在线数据等,采用集中管理、标签区分、按需抽取的方式灵活构造。

3)可灵活支持开发训练、验证推理环境需求,以及离线、仿真在线、运行系统在线验证模式。训练环境和推理环境无本质不同,只是前者要求的配置较完整,以提供全过程支持,后者则可轻量化部署,侧重于以(接近)实际场景获取AI模型的功能、性能验证数据。对于类似在线验证的需求,可通过引入电网仿真器、接入在线运行系统等方式实现。

1.2 系统架构设计

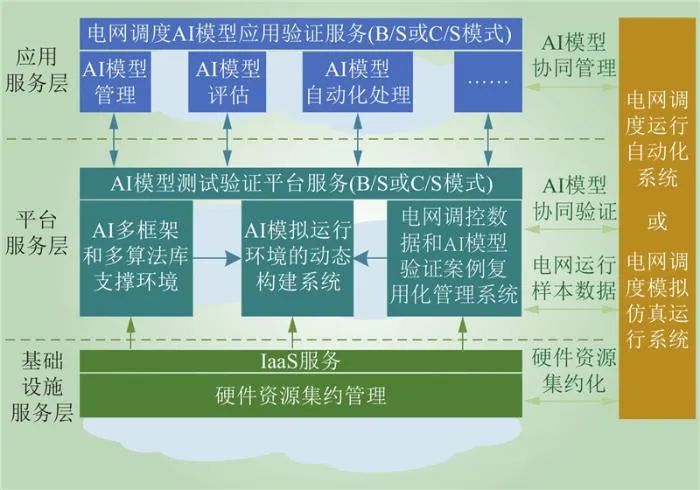

基于云计算思路,结合验证平台实现目标,设计了如图1所示的3层总体架构。

Fig.1 Verification platform system architecture

基础设施服务层(infrastructure as a service,IaaS):主要实现对硬件资源(CPU、GPU、TPU、存储、网络资源等)的虚拟化和资源池管理,可实现虚拟机级别的动态伸缩性,类似技术已经比较成熟。

平台服务层:在IaaS服务的基础上,实现对各类AI框架和算法的支持和管理、对各种场景下验证案例(包含电网模型和样本数据)的管理,然后通过基于容器和镜像的动态环境构建,对上层提供AI模型训练和验证服务。

应用服务层:实现对系统中AI模型的管理、评估和各类自动化处理功能,对外以客户服务器(C/S)或浏览器(B/S)方式提供AI模型训练和验证服务。

系统不同层级可外接各类电网调度仿真模拟系统或实际运行的自动化系统,实现硬件资源集约化、电网模型和数据共享、AI模型训练和验证全流程支持等功能。

1.3 运行模式

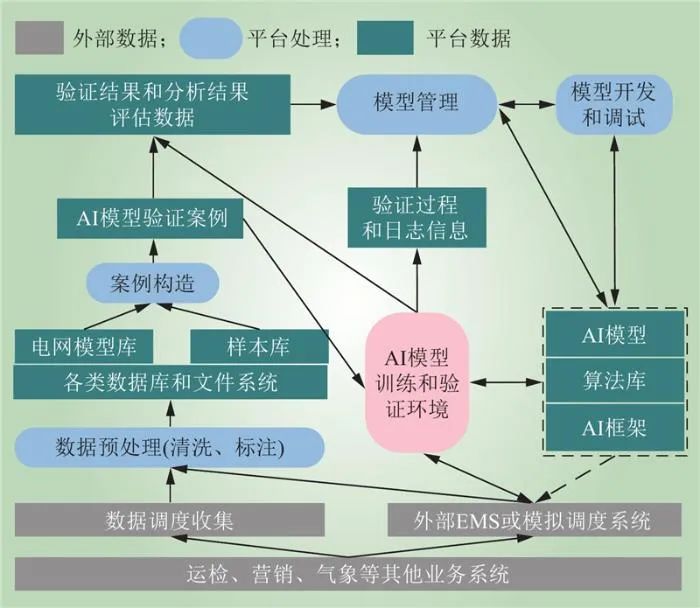

系统以AI模型和验证案例为基础,形成如图2所示的以验证环境动态构建为核心的运行模式。

调控应用涉及的各类外部数据(包括各调控专业和相关系统数据),经过数据预处理,形成验证平台内部的基础数据(电网模型及其关联样本数据),并按需构建验证案例。AI模型和验证案例可在训练和验证环境容器中使用,并根据需要外接模拟或实际EMS系统,形成双向闭环交互。验证的过程和日志信息上传至应用服务层,形成验证结果和模型管理基础信息,并可以提供给AI模型开发和调试过程,形成闭环。

02

关键支撑技术

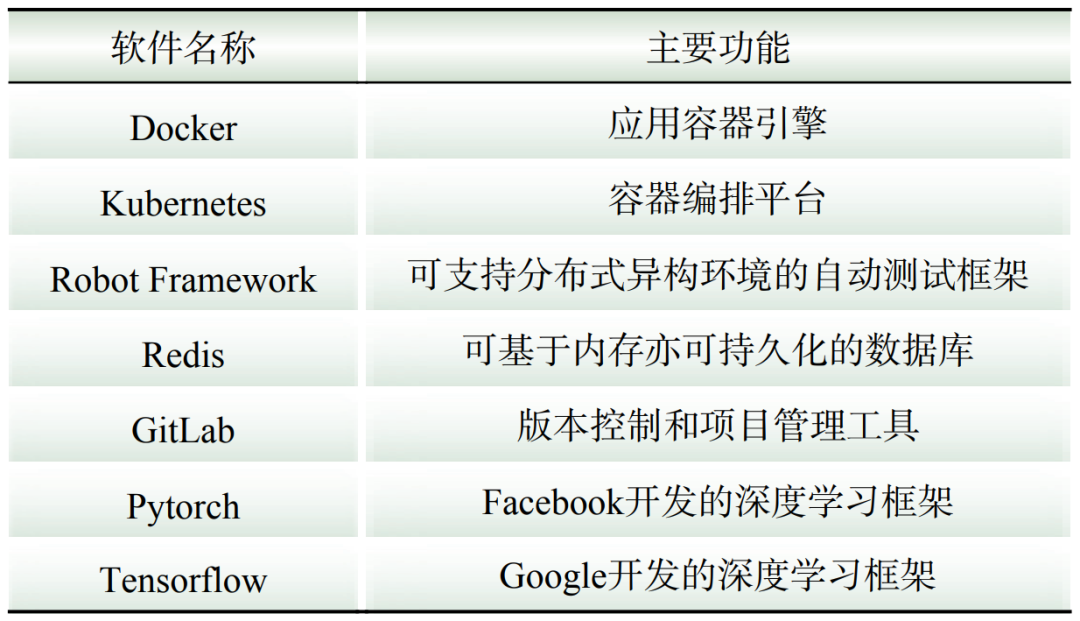

当前,虚拟机、容器和镜像、各类AI框架等ICT技术发展迅速,并且开源成为软件发展的重要潮流,在加强源代码审查和管理的前提下,仍可以满足自主可控的国产化要求。典型的相关开源软件如表1所示。

表1 典型开源软件Table 1 Typical open source software

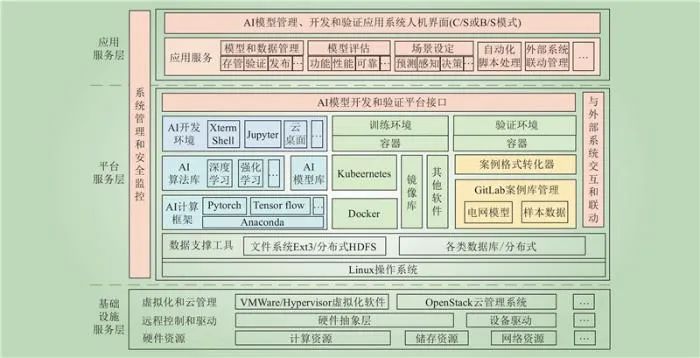

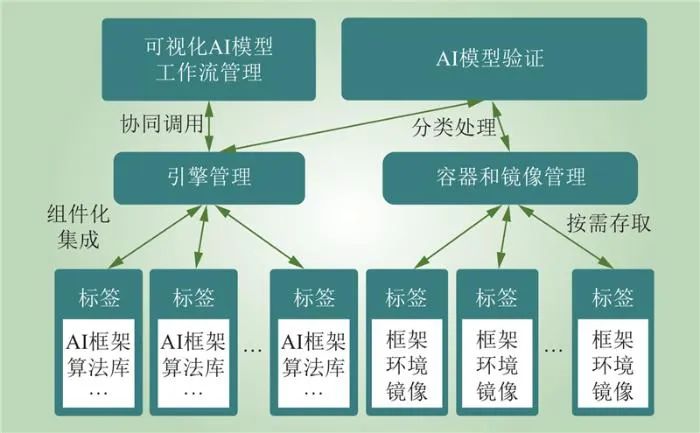

在此基础上,图3给出了验证平台的技术实现架构。它具有以下特点。

图3 验证平台技术实现架构

1)基础设施层:基于VMware、云管理系统等软件,实现基础设施服务的虚拟池化和共享。

2)平台服务层:利用Docker的沙箱机制,开发者可以将应用环境打包到一个容器中,然后发布到任何目标虚拟机上,Kubernetes则进一步实现对Docker容器的调度管理。利用GitLab服务,以“仓库管理+资源标签”的形式集中管理电网模型和样本数据,然后按需抽取,经格式转换后形成验证案例。

3)应用服务层:统一对外提供包括模型和数据管理、模型评估、场景设定、自动化脚本处理、外部系统联动管理等服务。

4)硬件算力资源的综合管理:基础设施层通过把硬件算力分配给虚拟机,实现虚拟机级别的调度;平台服务层通过为容器分配虚拟机中的算力资源,实现容器级别的调度;验证平台在Kubernetes基础上,通过GPU虚拟化技术,进一步允许同一块GPU挂载给多个容器(每个容器只占用其中一部分),从而减小算力资源调度的单位,提高使用效率;在整个多层级算力资源调度的基础上封装为平台层服务,屏蔽用户对于底层的直接访问。

2.1 案例和样本

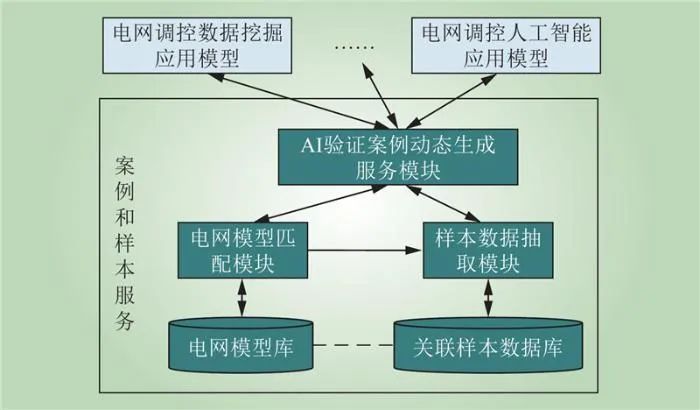

复用调控应用的数据与电网信息模型紧密关联。在已有标准规范,如CIM/XML或者CIM/E格式基础上,结合文件和数据库工具,形成如图4所示的技术方案。

利用GitLab和数据库分别保存电网模型文件和样本数据,同一个电网模型可以在不同的时间段有多个标签,表示其可满足多类需求。根据AI模型验证需求,通过标签匹配检索出目标电网信息模型,然后从数据库中抽取所需要的样本数据,再按需合成指定形式的案例(例如csv、txt、Excel文件等格式)。验证案例的推荐过程,其实也是从验证需求到验证案例的映射过程。

平台可以基于积分对各类案例进行排序推荐,典型计算方法为

式中:V为案例最终积分;i为不同的案例编号;ε∈[0,1],为配置参数,表示推荐模型时对模型多样化要求权重;N为本次验证需求数;wj∈[0,1],为本次第j项模型需求的权重,且xi为第i个案例;M为案例库中案例总数;p(xi)为案例xi最近使用的频度,其初值为1/M(开始时所有案例等可能性使用),随着使用过程,验证平台同步更新各案例的有效使用频度值;f(xi,j)∈[0,1],为案例xi对第j项模型需求的满足程度,完全满足则取值为1。

在此基础上,使用者可以进一步人工选择采用其他策略确定最终验证案例集,例如交叉验证、留出法等。

2.2 容器镜像

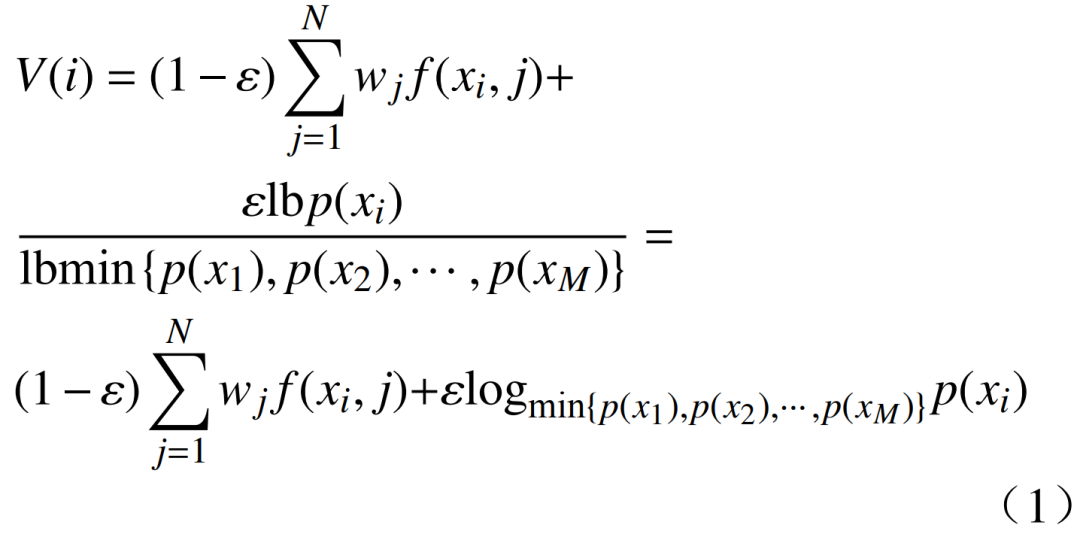

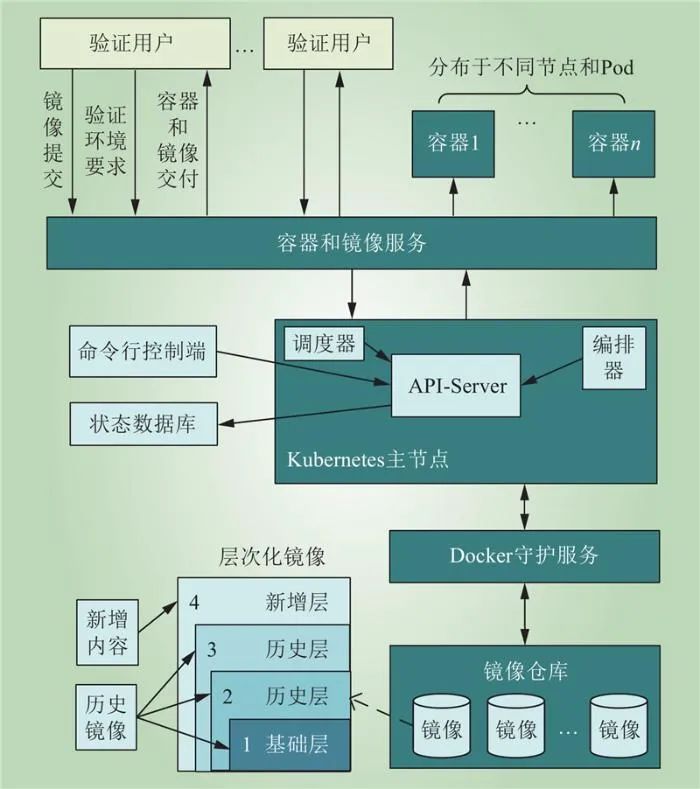

利用Kubernetes和Docker的容器和镜像机制,形成了如图5所示的技术机制。

图5 容器和镜像服务

Fig.5 Container and mirror services

利用Docker基于UnionFS(Union file system)文件系统的增量镜像机制,按需把不同AI运行环境打包保存在镜像仓库中, 然后为不同验证需求提供轻量级、跨平台容器运行环境。Kubernetes则进一步基于环境需求和调度策略配置,对多个节点上的容器以Pod为单位进行调度(一个Pod中可以包含1个或多个容器)。

验证平台在此基础上进行封装,形成相比于虚拟机更细粒度的容器资源调度和基于镜像的对多种运行环境的支持。

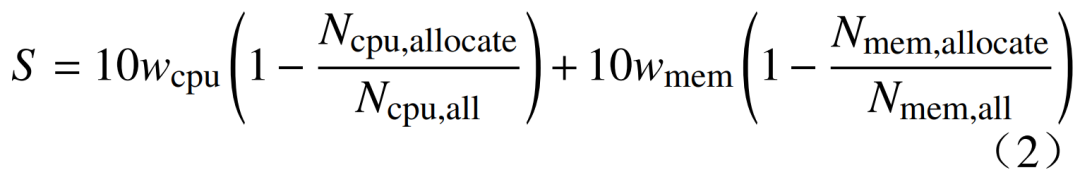

验证平台通过设置CPU限值、内存限值等控制容器资源配置,通过CPU使用率、内存压力、磁盘吞吐量等指标实时监视资源使用情况,并决定后续的调度策略。例如,在Kubernetes中一种最低请求优先级(least requested priority)函数会优先把容器分配到空闲节点上运行,其打分方法为

式中:S∈[0,10],为某节点的资源优先级;wcpu、wmem分别为计算资源、内存资源所占权重,通常wcpu=wmem,均取值0.5;Ncpu,allocate、Ncpu,all分别为该节点上已分配的计算资源和计算资源总量;Nmem,allocate、Nmem,all分别为该节点已分配的内存资源和内存总量。

2.3 多框架和算法集成

当前不同AI框架所支持的开发语言,对模型结构、参数和权重的表达方式,对脚本、配置和部署要求,所依赖的算法库等,都可能有较大差异,而PMML(predictive model markup language)、ONNX(open neural network exchange)等跨框架的标准序列化格式,尚未得到广泛支持。因此,AI模型很难独立于开发时的基础框架环境。

基于这种现状,采用了如图6所示的技术。

1)平台直接安装了互不冲突的若干版本AI框架和算法库,并建立相关的引擎管理模块。如果待验证的AI模型所用框架已直接安装,则可以通过引擎管理直接调用。验证平台并且开发了可视化AI模型工作流管理工具,支持在验证平台上直接以可视化方式开发、训练和验证AI模型。

2)对于更多的AI框架和算法库以及运行环境要求,则事先封装为镜像,使用时按需分配容器,载入相关镜像。

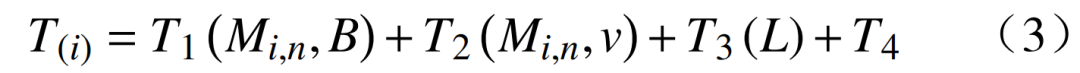

完整的AI容器化运行环境准备时间可表示为

式中:T(i)为第i个镜像总时间;Mi,n为第i个镜像中本地环境中所没有的n层镜像的大小,Mi,n通常小于第i个镜像的总体大小,因为基于Docker的分层镜像机制,并不重复拉取和加载本地环境中已有的镜像层;B为下载镜像速度(通常体现为网络带宽);T1为下载镜像所需要的时间,近似于Mi,n/B;v为存储设备速度;T2为镜像解压、加载所需要时间,它是Mi,n和S的函数;L为当前验证平台的负载情况;T3为容器调度分配时间,耗时取决于L;T4为容器初始化、设置命名空间等操作时间。

2.4 验证环境的灵活组态管理

灵活组态进一步扩大了平台组件的复用性,

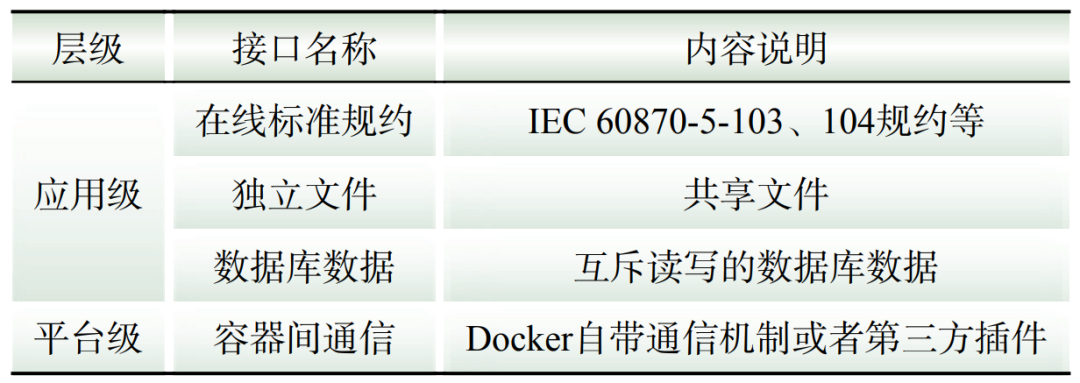

表2列出了可配置选用的系统/模块间交互方式。

表2 可选系统/模块间交互方式

Table 2 Optional system/module interaction methods

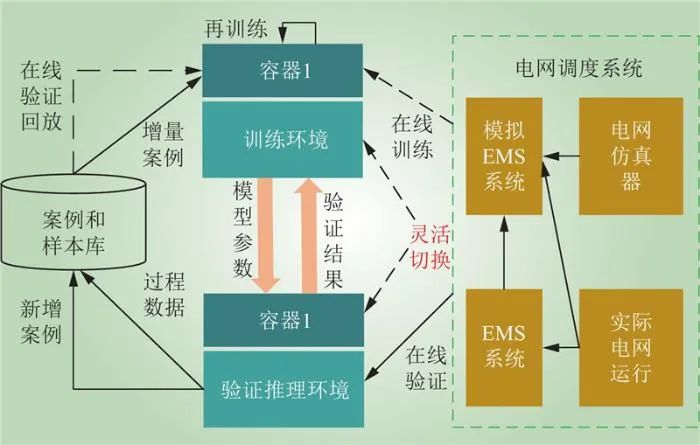

验证平台提供了如图7所示的多种组态模式。

图7 验证环境的灵活组态

Fig.7 Flexible configuration for verification environment

基于不同环境配置,验证平台可支持以下功能。

1)离线训练和验证:基于引擎管理、镜像和案例服务,可为AI模型分别提供训练和推理环境以及离线案例,并且基于文件命名空间、容器间通信等方式,可支持容器环境间交互。

2)在线闭环训练和验证:通过外接“模拟EMS系统+电网仿真器”(相互间可配置通信规约,目前常用104规约)或者实际运行的EMS系统,可以实现在线验证。在线系统可以连续反馈,从而持续产生新的动态验证案例。在线闭环模式和离线模式也可以灵活切换,区别主要在于数据源不同。

3)增量学习模式。增量学习属于以已有知识为主、兼顾新变化的学习方式。对应用案例和样本库(属于历史案例)、在线闭环反馈信息(属于新增案例)的综合应用,可以支持AI模型在保留既有知识基础上,不断适应新的环境变化。

2.5 其他关键技术

在安全性保障方面,验证平台本身属于专有系统,连同在线连接的仿真模拟系统,原则上都与外部网络隔离,如果在线连接实际EMS系统,则还必须符合相关安全区和隔离、加密规定。此外,验证平台内部,通过给每一个用户/用户组分配不同的角色,进而把不同系统、数据访问权限与角色关联。在保障不同用户/应用的资源隔离方面,提供了3层隔离。1)Docker自带的命名空间、控制组和容器隔离机制。2)在Docker基础上对镜像、网络、资源配额的管理。3)IaaS的虚拟机级别隔离。

在自动化验证方面,基于Robot Framework,在每个容器环境中部署守护进程,从而支持基于脚本的分布式协调的远程自动化验证。

在模型评估方面,基于典型框架的内置函数或者自定义函数,以及TensorBoard的数据可视化支持,实现对相关模型验证结果指标的自动计算和可视化展现,例如准确率、查准率、查全率、平均绝对误差、均方误差等。

在平台性能提升方面,综合应用了多类技术。1)基于虚拟机+容器技术,实现轻量化部署。2)利用云平台的动态伸缩、容器的动态编排和资源配置实现资源动态分配和回收。3)利用Kubernetes和Web代理nginx的流量分发和弹性管理机制,实现验证平台的负载均衡。

03

系统开发和实施

基于前述设计,开展了验证平台的开发和部署应用。目前,验证平台已集成各级电网模型20多套,管理各类人工智能模型超过1000个,能够支持用户数不少于200个,其中并发使用数量不少于50个,生成单个基础运行环境时间不超过1 min。

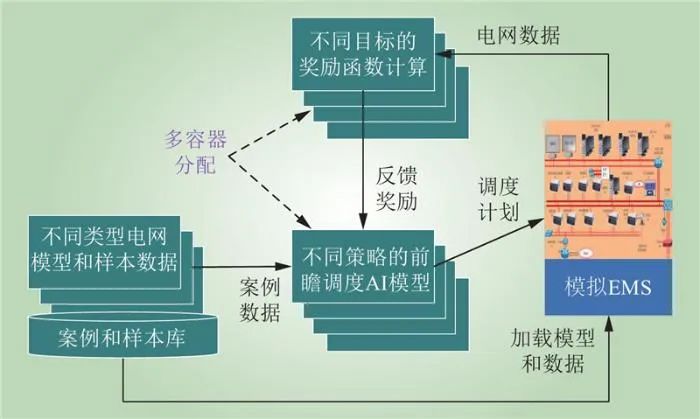

数据驱动的前瞻调度是当前调控领域AI技术应用的一个重要课题,它基于AI方法对前瞻窗口(若干小时)内各种不确定场景及组合进行推演,通过奖励函数综合考虑线路最高负载率、断面越限率、负荷不平衡量、新能源消纳率、经济运行成本等因素,滚动给出最可能场景的有功计划巡航路径。图8为验证环境组成示例。

图8 数据驱动的前瞻调度验证

Fig.8 Data-driven prospective scheduling verification

1)解耦了样本数据与AI模型的关联性。所有案例都来自统一的案例样本库,只是根据需求分别进行了抽取和再组织。2)适应了AI模型对框架的依赖。对不同的AI开发框架,能够直接在平台上或者基于镜像的容器环境中得到支持。3)能够输入多种电网拓扑、发用电曲线、灾害事件场景案例,对AI模型的训练、验证和迁移学习提供充分支撑。4)通过不同的容器化部署,能够并行化进行各种机器学习算法、多种调度目标奖励函数的验证和比较。

通过验证平台的实施,实现了以上电网仿真器、模拟EMS 系统、相关案例/样本数据以及AI运行环境的组态复用。

04

结语

数智化发展是当前新型电力系统技术发展的重要趋势,但是目前调控领域AI技术应用的验证工作仍属短板。本文提出了一个3层体系的高复用性验证平台框架,分析了该框架的运行模式,开展了相关关键支撑技术的研究、开发和实施。通过案例和样本数据的动态生成、对各类型AI框架和算法库的支持以及验证环境的灵活组态,最终形成了硬件资源、数据资源、运行环境资源(容器)、应用服务资源(统一服务接口)等各类“资源统筹”,不同容器、应用、案例数据之间“逻辑隔离”的调控领域AI模型验证生态。

后续需要进一步提高验证平台的自动化和智能化水平。当前,验证平台只是提供了必要的信息和模型存储、管理和验证支撑服务,在数据采集、预处理、系统互联、案例构建、分析评估等各个环节中都存在需要人工介入的情况,自动化程度还有很大提升空间,同时作为AI应用验证平台,其本身的智能化也是非常值得关注的方向。

实际上,AI技术是一个正在加速发展的领域,目前主要包括计算机视觉、语音识别、自然语言处理、传统机器学习、新一代机器学习、大(语言)模型等,特别是生成式大模型,已成为近期新一代AI技术发展的制高点,需要验证平台不断完善设计,适应AI技术的高速发展。